Actually secure boot on Fedora 39

Created: 07.10.2023 20:48 UTC

If you've set up actually secure boot as previously described on this blog on your Fedora installation, you need to make some changes when updating to Fedora 39. Luckily, updating to Fedora 39 won't break your system - it just means the kernel won't be updated anymore. However, this would turn into a problem as soon as dnf removes the modules for the kernel you are using.

As Fedora 39 and systemd-boot worked towards using UKI, some things got changed. In particular, the order of install scripts is different now, and 100-combine-and-sign.install was run too early (it should have been 99). On top of that, objcopy can no longer be used to create an .efi file with the systemd-boot stub and ukify needs to be used instead.

In order to make updating kernels work again, do the following:

sudo rm /etc/kernel/install.d/100-combine-and-sign.install

curl https://blog.nil.im/files/99-combine-and-sign.install | sudo tee /etc/kernel/install.d/99-combine-and-sign.install

# Review the code that was downloaded and printed at the same time by tee.

sudo chmod +x /etc/kernel/install.d/99-combine-and-sign.install

sudo dnf install systemd-ukify

sudo dnf reinstall kernel-core

If you reboot now and execute uname -r, it should contain .fc39 instead of .fc38. If rebooting does not work, boot the linux-old.efi, make a backup of it (e.g. linux-working.efi) and contact me.

ObjFW 1.0.1, 1.0.2 and 1.0.3 released

Created: 15.09.2023 23:36 UTC

ObjFW 1.0.1, 1.0.2 and 1.0.3 have been released. You can find further information here.

In general, I plan on having more regular releases now, which means I will only write about major releases here from now on. In order to get updates on every release, please subscribe to the ObjFW account on the Fediverse / ActivityPub (sometimes also called Mastodon, even though this instance isn't Mastodon), which is also available as an Atom feed.

ObjFW 1.0 has been released!

Created: 29.08.2023 17:36 UTC

Finally! Almost 6 years after the last unstable, I released ObjFW 1.0 today. This means the API and ABI are finally stable and overall everything should be in a good shape.

I screwed up the ObjFW Git repository

Created: 18.06.2022 19:44 UTC

Today, I realized that I screwed up the ObjFW Git repository, while the Fossil repository was fine at all times. You need to delete your clone and do a fresh clone if you checked out ObjFW via Git. Other repositories are not affected and only the master branch is affected - more on that later.

So what happened? In December 2021, shortly after Christmas and before New Years, my server died. The remote console reported a power supply failure, nothing that could be fixed remotely. And unfortunately, because it was between the years, it was impossible to get to the data center and fix the server (I would have had a spare PSU - but I was also in a different country). So I decided to set up the services that were on said server on my RockPro64, which at the time was already hosting my Matrix server. And this is where the mistake happened.

At this point, I need to go back a step and explain how the mirroring of the Fossil repository to Git works. On my server, there's a cronjob every 5 minutes that checks all Fossil repositories and exports all new commits to Git and pushes them to GitHub. Because Fossil deals with user names and Git with real names + e-mail addresses, some mapping is needed. Because Fossil's fossil git export command lacks support for such a mapping (see my previous blog post on this), I patched this mapping into the code itself. I build Fossil using pkgsrc, which makes it easy to maintain a local patch set. When I recreated this patch set on the RockPro64, I was in a huge hurry to restore all my services and made a typo: I typoed my last name in the mapping. My laptop's keyboard is sometimes bad at debouncing keys, so sometimes letters repeat, and this is exactly what happened. And given the hurry I was in, I didn't notice.

So what happened? Well, computers being computers, they do what they are told. So for half a year, it would happily push with the wrong name. And I wouldn't notice for half a year, because GitHub had the brilliant idea to fake that repositories only have a GitHub user name and not a real name + e-mail. Yes, they go through quite some length in their UI to act like Git uses GitHub user names and not real name + e-mail and make sure you never ever see a real name for a commit anywhere - you need to git clone to see that. Which in this case made sure that I would never see the typo, since I don't check ObjFW out via Git myself but only via Fossil. This is yet another case where GitHub's stupid idea to lie about commit authors caused harm (not to mention people leaking their real name when they don't want to and not noticing because GitHub acts like it's not there).

And because fixing this typo of course results in different Git commits being created, exporting from Fossil to Git after the fix rewrote all Git history since January 2022. The Fossil history of course remains unchanged and isn't being rewritten. Sorry for any inconvenience this causes.

So, why are other projects not affected, and only the master branch on ObjFW? Simple: Because I didn't even set up the mirror for anything but ObjFW's master branch when I was in the rush to restore my server and hence access to my digital life.

Blog software rewritten

Created: 02.01.2022 13:29 UTC

A few weeks ago, my server died, as some of you might have noticed. My old server was a SPARC64 machine running OpenBSD and the blog still existed as an old static binary. ObjFW's code changed plenty in the time, so it needed some updating in any case. But the new machine is no longer running OpenBSD, which added an additional problem: OpenBSD has a daemon in base called slowcgi, which can be used to make regular CGI applications speak FastCGI. The blog was still using CGI and nginx has no native support for that.

The natural solution would have been to just switch from slowcgi to something like fcgiwrap. But given the amount of setup that would be required, I opted for something else instead: Rerwite the blog to use OFHTTPServer. This was surprisingly easy to port and basically worked on the first try.

The new code can be found at the same place, with one difference: There's only one binary now and atom support is served by the same binary. You only need the Blog.mMakefiletemplates, that's all.

Edit: The code is now in a repository.

Linux on the ASUS ROG Zephyrus G14 2021

Created: 05.09.2021 12:28 UTC

A few months ago, I got an ASUS ROG Zephyrus G14, 2021 version. I got it with the 5900HS, 32 GB RAM, RTX 3060, 1440p 120 Hz display and 1 TB of SSD. I never would have imagined that I would buy a gaming notebook, but AMD's current notebook offerings convinced me and this was the best machine in 14" that I could find (the Razer Blade 14 has been released since, but that's limited to 16 GB of soldered RAM). It doesn't feel like a gaming notebook, but rather an ultrabook with insane performance. Unfortunately, my vendor got a bad batch with display issues and sent me a replacement from the same batch several times, so the problem never went away, but that's a different story.

Today, I will talk about how to run Linux on the ASUS ROG Zephyrus G14 2021 and

do most things the Armoury Crate software does on Windows without any extra

software, as I have been asked to do so by a few people. There is also a

project called "ASUS Linux" which has a guide for Fedora, which many people

recommend, but I can only strongly recommend to not follow it: It

severely weakens system security for absolutely no other reason than being lazy

and I actually got banned from their Discord for raising these issues. There is

a complete lack of understanding of concepts such as priviledge separation and

priviledge drop and instead there's a daemon running as root. The author deems

this absolutely secure because the daemon is written in Rust (history shows

this to be a common misconception by those who have no clue about security -

just because something is written in Rust doesn't make it 100% secure, it only

eliminates a single class of security vulnerabilities) - while it links in

various graphics libraries with a bad security track record to handle

displaying images on the AniMe Matrix of the G14. So essentially, this is just

one exploit in libpng or similar away from a full kernel compromize, because

they also make you disable Secure Boot. And finally, they even tell people to

install a custom kernel from Copr that has very

questionable patches:

E.g. adding udelay to avoid a race condition. For those who don't

know what that means: That is a very ugly workaround that you should never ever

do in production and leaves the underlying issue entirely unfixed.

But not everything coming from the ASUS Linux project is bad: The author actually did write some very useful patches and upstreamed them, so credit where credit is due. And it is also thanks to those patches that I can write this guide that works with a stock kernel. This just shows that upstream works: The good patches go upstream, while the bad ones don't. That's exactly how it should be.

First things first: You should use a distribution that has a modern kernel. For the G14 2021, that means 5.12 is the absolute bare minimum. I'd recommend 5.14 or, once released, 5.15, which should make standby more reliable. I'm personally using Fedora, but everything listed here should work with any distribution running a modern kernel and systemd.

The big elephant in the room for most people is probably the dGPU. By default,

when no driver is loaded, it does not idle and sucks the battery empty in less

than 2 hours. I've been told installing the NVIDIA driver fixes this, but

personally, I do not use the dGPU on Linux other than for dGPU pass-through to

a VM. So I will not install the NVIDIA driver, given that this only adds a lot

of pain for no reason. If you do install the NVIDIA driver, that still does not

require you to disabe Secure Boot - don't! Follow something like my last blog

post instead on how you can set up your own Secure Boot keys and then you can

just sign the NVIDIA kernel module with that. You also don't need the NVIDIA

driver to pass the dGPU to a VM, in fact it's easier to do without the NVIDIA

driver. But we would still like to have more than 2h of battery life, so

there's an easy solution: Simply remove the NVIDIA card from the PCIe bus. You

can automatically do this on every boot by creating a file

/etc/tmpfiles.d/asus_gpu.conf and writing the following into it:

w /sys/bus/pci/devices/0000:01:00.0/remove - - - - 1

w /sys/bus/pci/devices/0000:01:00.1/remove - - - - 1

This way, the dGPU no longer uses any power. You can verify this (while running on battery, of course) using:

awk '{ print $1*10^-6 " W"}' /sys/class/power_supply/BAT0/power_now

You should get around 6 W when you dim the display and have an idle machine.

If you want to get the dGPU back, for example to pass it into a VM, simply rescan the PCIe bus:

echo 1 | sudo tee /sys/bus/pci/rescan

This machine also has 3 different fan profiles: Normal, silent and turbo. I

personally like my machine to be entirely quiet and with the silent profile,

the fans turn off completly if there is no significant load. I also like to be

able to control the fan without needing to be root, from my regular user. To

achieve both, create a file /etc/tmpfiles.d/asus_fan.conf and

write the following into it:

z /sys/devices/platform/asus-nb-wmi/throttle_thermal_policy 664 root js - -

w /sys/devices/platform/asus-nb-wmi/throttle_thermal_policy - - - - 2

Important: Replace js with your username!

Once you have done that, you can use a script such as this to toggle through the profiles. I bind it to the fan key in GNOME and it even shows me a nice notification which profile I have selected.

Lastly, another feature of Armoury Crate is to not fully charge the battery to

extend its lifetime. I am not sure how much difference this actually makes,

alas, we can do the same on Linux. Just create a file

/etc/tmpfiles.d/asus_battery.conf and write the following into it:

w /sys/class/power_supply/BAT0/charge_control_end_threshold - - - - 60

Replace 60 with whatever maximum percentage you want to charge it to. Obviously, you can also change this on the fly, e.g. if you want to charge to 100% again as a one-off before leaving the house:

echo 100 | sudo tee /sys/class/power_supply/BAT0/charge_control_end_threshold

If you do that often, you might consider adding a z line similar

to what we did in asus_fan.conf so that you don't need

sudo.

That's it. If there's anything more you would like to do that Armoury Crate can do that I forgot about, please contact me and I'll have a look.

Actually secure boot on Fedora

Created: 12.08.2021 20:11 UTC

A few months ago I purchased a new notebook which supports Secure Boot. It is actually my very first machine with Secure Boot support on which I want to run Linux (the only other machine I have which supports Secure Boot is my gaming rig, which exclusively runs Windows as it has no other purpose than playing games).

While at first I was happy to finally have a somewhat secure boot chain, the disappointment came quickly: Pretty much all Linux distributions which support Secure Boot use a shim called shim which is signed with a key from Microsoft. shim then checks the signature of the kernel against certificates stored in an UEFI variable and failing that falls back to checking against the Secure Boot keys stored in UEFI. While I do believe that UEFI somewhat protects its own certificate store, I am not so sure about that of shim.

But this is not the only problem with the default Secure Boot setup on Fedora and most other distributions: The initrd is not verified at all! Yes, that's right - someone can just put a malicious initrd on your unencrypted /boot partition and there is absolutely nothing that prevents it from being loaded! The kernel and GRUB (at least by default) only implement the bare minimum for Secure Boot: Making sure that no unsigned code runs in kernel space while entirely ignoring everything that would compromize user space. That makes Secure Boot entirely useless by default, as compromizing the initrd is even much easier than comprimizing the kernel: Just swap the /sbin/init in the initrd with a shell script that opens a backdoor and then calls the real init instead of cumbersomely inserting a backdoor into the kernel.

So, is Secure Boot entirely useless? No! It is just that the way all Linux distributions use it by default is entirely useless, because their goal is to get everything signed by Microsoft so that users can boot the system without needing to reconfigure Secure Boot. Their goal lis not to be secure. But we can fix all of that! The idea is to combine the kernel, initrd and boot options into a single .efi file that we sign with our own key.

So first of all, we need to switch from GRUB to systemd-boot. But wait! Don't go follow any tutorial on how to do that - because we're doing things a bit differently. So why do we need to switch? GRUB is very hard to secure. It reads many unverified files and its configuration is by default entirely unverified. It also by default does not verify the initrd. With a lot of work and assembling your own GRUB, it is possible - but this is very error prone, fragile and GRUB recently changed things around so that all the instructions that you will find on how to let GRUB verify everything are outdated. systemd-boot on the other hand is simple: You take the systemd-boot stub, the kernel, the initrd and the boot options and merge it into a single .efi file that you then sign.

Now is a good time to have a Fedora DVD ready to boot in case you break something! Do not proceed if you have no medium to boot from for recovery!

To uninstall GRUB, do:

sudo rm /etc/dnf/protected.d/shim.conf

sudo dnf remove shim\* memtest86+

Do not reboot now! Your machine is in an unbootable state now!

Time to save the kernel boot options:

cat /proc/cmdline | cut -d ' ' -f 2- | sudo tee /etc/kernel/cmdline

Next, we need to generate a few keys. But first, let's look at what keys Secure Boot has:

This means you can import a DB or DBX from a booted system if it is signed with a KEK, and you can import a KEK from a booted system if it is signed with the PK. If you import it directly in the firmware (we will do this later), no such signature is needed. But you still need a PK and KEK, as otherwise Secure Boot will remain in setup mode - meaning the OS can import keyes without requiring a signature.

We need to generate our own PK, KEK and DB. To generate those keys, we do the following:

sudo dnf install openssl

sudo mkdir /etc/secureboot

sudo chmod 700 /etc/secureboot

sudo openssl req -new -x509 -newkey rsa:4096 -subj "/CN=$(hostname) PK/" -days 36500 -nodes -sha256 -keyout /etc/secureboot/pk.key -out /etc/secureboot/pk.crt

sudo openssl req -new -x509 -newkey rsa:4096 -subj "/CN=$(hostname) KEK/" -days 36500 -nodes -sha256 -keyout /etc/secureboot/kek.key -out /etc/secureboot/kek.crt

sudo openssl req -new -x509 -newkey rsa:4096 -subj "/CN=$(hostname) DB/" -days 36500 -nodes -sha256 -keyout /etc/secureboot/db.key -out /etc/secureboot/db.crt

sudo openssl x509 -in /etc/secureboot/pk.crt -outform DER -out /etc/secureboot/pk.cer

sudo openssl x509 -in /etc/secureboot/kek.crt -outform DER -out /etc/secureboot/kek.cer

sudo openssl x509 -in /etc/secureboot/db.crt -outform DER -out /etc/secureboot/db.cer

sudo sh -c 'cp /etc/secureboot/*.cer /boot/efi'

We won't need the unencrypted /boot anymore, so let's move /boot to the encrypted root partition so that nobody can swap the kernel or initrd on the unencrypted /boot partition and trick us into signing it later.

sudo umount /boot/efi

sudo cp -a /boot /bootx

sudo umount /boot

sudo rmdir /boot

sudo mv /bootx /boot

sudo mount /boot/efi

sudo -e /etc/fstab # Remove /boot from it, but not /boot/efi

In order to automatically merge systemd-boot, the kernel, initrd and the boot options into a a single .efi file and sign it when a new kernel is installed, I wrote a kernel-install hook. All you need to do is drop 100-combine-and-sign.install into /etc/kernel/install.d and make it executable. After adding this file, do the following and you should end up with everything as a single, signed .efi file:

sudo dnf install systemd-boot sbsigntools binutils

sudo mkdir -p /boot/efi/EFI/Linux

sudo dnf reinstall kernel-core-$(uname -r)

That's it from the Linux side. Now it's time to go into your UEFI settings: Change the file to boot to EFI/Linux/linux.efi. Then clear all existing keys (PK, KEK and DB - you can also clear DBX, as it is now useless: it only contains hashes you could not boot anyway) and import the PK, KEK and DB that we copied to the EFI partition (you can and should delete those from the EFI partition after importing them). And obviously, set a UEFI password (but if you read this guide, you probably are the kind of person who already has that anyway, right?). If everything worked, your system should come up again now. Good luck!

If you like to clean up, you can actually get rid of all files in /boot/efi except for /boot/efi/EFI/Linux/linux.efi. Use dnf provides /boot/efi/foo to see which package added the unnecessary files and uninstall them.

Edit: Please see here if you are running Fedora 39, as things changed in Fedora 39, requiring changes to this process.

Incrementally exporting a Fossil repository to an existing Git repository

Created: 28.05.2020 18:48 UTC

As mentioned in my last blog post, I recently migrated ObjFW from Git to Fossil, while still keeping to commit to the Git repository, with an automatic conversion to Fossil.

This incremental and automatic export to Fossil worked well, but it was slow,

as the fossil import workflow always requires rebuilding of the

metadata, as otherwise a fossil pull would not pick up the

changes. Also, Fossil supports some nice features that Git does not, like

giving colors to branches, so I was missing out on these features by using that

workflow.

So I looked into committing to Fossil and exporting to Git instead. Which is

something that is supported out of the box using fossil git

export. However, it can only export to a new repository, not to

an existing repository. This would have meant I would have lost all Git history

and everybody would be required to delete their checkout and create a new one.

Not only is this rewriting history and cumbersome, but it also has the risk

that if there were problems during the conversion, the good state would be lost

forever.

Therefore, I looked into how to make this work with an existing repository.

Since this works incrementally, there has to be a way to keep state, right?

There needs to be a way to keep track of what Git commit matches what Fossil

commit. And that's exactly what the marks files generated by git

fast-export and fossil import do.

When I converted the repository to Fossil, I used the following (simplified, not the actual commands that I used since there were some hoops necessary to cross security boundaries on my server):

# This is important if there is any non-UTF-8 anywhere in the repository

export LC_ALL=C

git fast-export --all --signed-tags=strip --export-marks=git.marks |

sed 's/^committer Jonathan.*>/committer js <js>/' |

sed 's/^author Jonathan.*>/author js <js>/' |

sed 's/^tagger Jonathan.*>/tagger js <js>/' |

USER=js fossil import --git --rename-master trunk \

--export-marks fossil.marks repo.fossil

For later invocations, I then added --import-marks of the same

marks file to both git and fossil for the incremental

import. The sed invocations are necessary so that the commits get

the correct user js instead of the e-mail address being used as

the username.

The resulting marks files contain a mapping for mark id to Git commit and mark

id to Fossil commit. When using fossil git export to create a Git

repository again from the converted Fossil repository, I noticed that it

creates a .mirror_state/db file in the target Git repository. This

file is an SQLite3 database with the mapping between mark id, Fossil commit and

Git commit and is used for incremental Git exports. So I wrote a

small program that parses the

marks files generated during the initial conversion and later incremental

imports and generates the .mirror_state/db file for an existing

repository. After creating this file in the existing repository, a normal

`fossil git export` now just incrementally exports to the existing Git

repository without rewriting any history.

Now only one problem remained: fossil git export always uses

username@noemail.net as the committer name

(code).

This means the commits are not properly attributed on GitHub. I fixed this by

just hardcoding a fossil_strcmp() against js there

and then emitting my e-mail address instead. But of course the proper fix would

be to refactor the

code from

the deprecated export command to be reusable by the new export.

Finally, I set up a cronjob that runs every minute that exports from the Fossil repository to a checked out (important - exporting to a bare repository doesn't work!) Git repository and pushes that, to both my Git server and GitHub. This is fast enough to run it every minute, unlike the other direction (for which I hacked around the expensiveness of the metadata rebuild, which even happens when nothing changed, by doing some checks first if there's actually new commits since the last import).

You can see a Fossil commit here and the Git commit that was automatically created by this process.

New ObjFW homepage

Created: 23.05.2020 19:42 UTC

Today, I finally created a new homepage for ObjFW - by using Fossil!

The content is still mostly the same, but that will change in the coming days.

Fossil is a VCS that also comes with a wiki, ticket system, forum and many things more - all in a single binary and all part of the repository.

Since ObjFW is using Git, I had to convert the Git repository to Fossil. It was clear from the start that I will always need to have a Git repository, as that is what people are familiar with, but it was unclear whether I want to export the Fossil repository to a Git repository or the Git repository to a Fossil repository. Since converting from Git to Fossil went flawlessly (and I could even finally recover those old branches from the times of using Mercurial!), while I could not export back from Fossil to Git without rewriting all history (it cannot export to an existing repository), that is what I'm doing for now. There is a cronjob running that checks for new Git commits and adds them to the Fossil repository (currently every minute, but I might change frequency).

So, what does that mean for you, the user? What should you use? The answer is easy: It doesn't matter. Both repositories will be treated as first class citizens, so whether you use Git or Fossil is entirely up to you. But for issues, the wiki and forum: Please use Fossil and not GitHub. It's easy to create an account: Just click on login, then register and you're done! And almost all existing issues and wiki pages have already been moved over to Fossil!

This also means there's a forum now to discuss about ObjFW! Hopefully soon there will be some discussions there!

ObjFW 98 SE: Bringing Objective-C to Windows 98 SE and NT 4.0

Created: 17.05.2020 20:34 UTC

Yesterday, I got the idea to port ObjFW to Windows NT 4.0. Considering the lowest supported Windows version so far was Windows XP, this seemed like it would not be too much work. However, the biggest problem was getting a toolchain that still supports Windows NT 4.0!

Just using an old MSYS2 on Windows XP (I had a Windows XP VM around anyway for

writing

IPX/SPX[1,

2]

support) and copying the resulting binaries to Windows NT 4.0 did not work: It

complained about not having AddVectoredExceptionHandler and

RemoveVectoredExceptionHandler. Of course: According to MSDN,

those were introduced in Windows XP. Grepping the GCC sources did not yield any

results, but grepping the entire MinGW sources did: It's used in winpthread.

And luckily, it's only used for thread names, so commenting out two lines and

recompiling it was enough. winpthread is linked by GCC by default, because the

exception handling runtime needs it - and we really want exceptions for ObjFW.

After the compiler no longer created binaries that had missing symbols on

Windows NT 4.0, I got an OFInvalidFormatException loop: MinGW's

implementation of asprintf seems to call into

snprintf and expects it to return the number of bytes that would

have been written if a sufficiently large buffer were provided. But on Windows

NT 4.0, it only returns -1 if the buffer is too small. And trying to print the

error of course calls into it again, hence the loop. Unfortunately, my own

asprintf implementation relied on the exact same

snprintf behavior - it's part of the C89 aleady, after all! So I

had to work around it

- easy enough. After that, I was able to get a "Hello world" using

of_stdout and OFApplication:

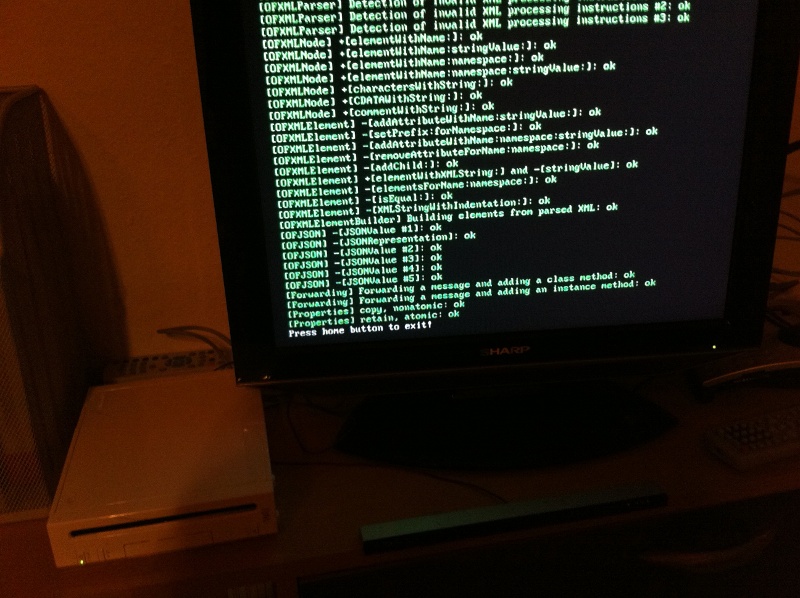

And a few minor changes later, all tests were running successfully:

Well, not all of them: I had to disable sockets, as with them, something would

try to load icmp.dll, which does not exist on Windows NT 4.0. I'll

look into that another time.

Later that evening, I wanted to take things further and thought: If we have

Windows NT 4.0 now, why not Windows 98 SE as well? This is more difficult,

though: Windows has two versions of almost every API: An A version

and a W version. A wrongly stands for ASCII, while

W stands for wide. Meaning the A version takes all

arguments in the native, locale-dependent codepage, while the W

version always uses Unicode. The W versions were only introduced

with Windows NT and ObjFW used the W versions exclusively. Since

the Windows console is quite bad and needs some nasty hacks

to be made bearable at all, it meant I could not even get a "Hello world"

without porting those hacks to the A APIs first. So I added a

fallback for when the

W version returns ERROR_CALL_NOT_IMPLEMENTED (all

W APIs return that error on Windows 95/98/ME), got a working

"Hello world" and called it a day (unfortunately I forgot to take a screenshot,

as it got quite late).

The next day, I decided that calling the W version first and only

falling back to the A version if it fails with

ERROR_CALL_NOT_IMPLEMENTED doesn't make a lot of sense: After all,

there is never gonna be a non-NT version of Windows that supports Unicode. So I

decided to add an API

to detect if ObjFW is running on Windows NT and

used that instead.

While I already had a "Hello world" working, it was not one using

OFApplication, but just using of_stdout in

main. So in order to get that working, I

ported

OFApplication to the A APIs and finally got a

proper "Hello world". So now it was time to

port everything else to

the A APIs and voilà, all tests are running successfully:

Well, not all of them: For Windows 98 SE, in addition to disabling sockets, I

also had to disable DLLs and threads. For DLLs, I have not figured out yet why

it doesn't work, but for threads, I already know what it is and how to fix it

(WaitForSingleObject does not support waiting for threads).

And the coolest thing: This now results in a binary that works on anything from Windows 98 SE to Windows 10, using all features as available!

I guess that's not too shabby for a weekend and I'll see that I get all the remaining issues fixed. And who knows, maybe ObjFW 3.11 for Workgroups is next? ;)

Bringing Objective-C to the Amiga

Created: 23.04.2018 00:30 UTC

After porting ObjFW (and at the same time Objective-C) to MorphOS and starting to port it to AmigaOS 4, I thought: It's nice to have Objective-C on a modern Amiga-like operating system. But what if we could have it on the real thing, the classic m68k Amiga? And thus, I ported it to AmigaOS 3 today.

First things first, we need a compiler. No compiler modern enough to support exceptions in Objective-C was released for the Amiga itself, as there was never any GCC 4 for Amiga. However, there's a new cross-compiler around: bebbo's amiga-gcc. This is the successor to his amiga-cross-toolchain fork, which unfortunately downloaded lots and lots of archives via plain insecure HTTP and would then go to execute downloaded files, so I never really wanted that on my system. But amiga-gcc checks out everything from GitHub, and the few files it downloads never get executed on the system you build the toolchain on. So after some minor patches to make it build on macOS, I had a toolchain.

Getting ObjFW to compile was easy. But running the resulting tests binary immediately resulted in "Program aborted". Huh, that was strange - I was already expecting exceptions not to really work, but then the first test using exceptions would usually fail and not an immediate abort. So now I had to figure out what was aborting - not an easy task without having a debugger in which I can just set a breakpoint and look at a backtrace. So the first thing to try was creating an empty binary that just links in ObjFW and its runtime, to see if all the initialization worked. That worked, so I added exceptions into the mix. Now I got the same "Progam aborted" as with the tests. So I moved on to to add a #define for abort to print the source file and line and then exit. The first theory was that one of the switches in src/runtime/exception.m fell through and then called abort(). But this didn't catch anything, meaning it's not in my code. Usual suspects then would be libc and libgcc. So I went ahead and added the same #define to the libgcc sources and finally found what called abort: uw_init_context(). Ouch, that's bad, that's pretty much the first thing called by _Unwind_RaiseException(). uw_frame_state_for() returned _URC_END_OF_STACK, making an assert in uw_init_context() fail. Well, that should never happen, unless our DWARF info is garbage. I had tried exceptions with C++ before, which worked, so I knew that unwinding couldn't be entirely broken. Looking at the assembly output of a small test program that just throws and catches in both C++ and ObjC, there was no obvious difference. After trying several things for hours, including rebuilding the toolchain with Obj-C++ support and trying that and switching from amiga-cross-toolchain to amiga-gcc, which all failed, I finally found a way to make it work: When using m68k-amigaos-g++ rather than m68k-amigaos-gcc, it would suddenly work. I had tried compiling it as ObjC++ before by renaming the the testcase to .mm, but that didn't work. But naming it .m and using m68k-amigaos-g++, it worked. I have not figured out why it works this way, though, but at least now I have something that works. And according to m68k-amigaos-nm, it does not even bring any unnecessary C++ code in.

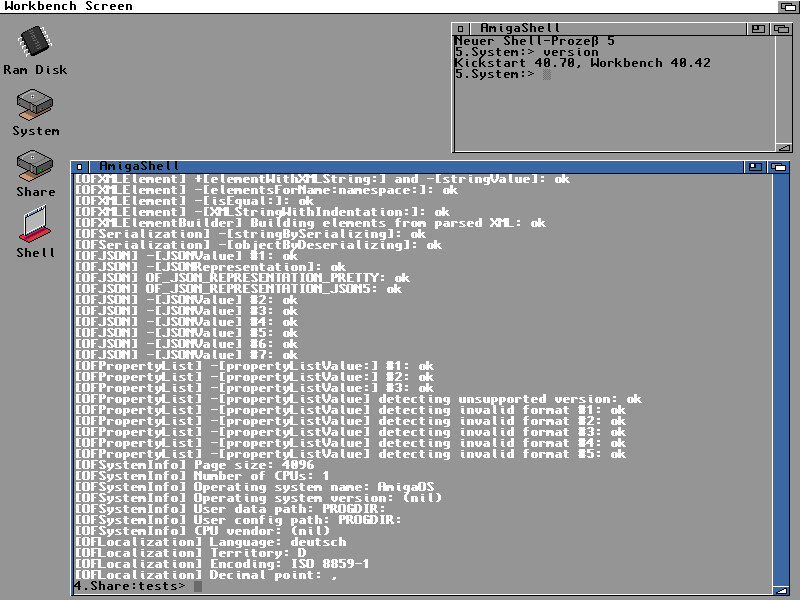

Shortly after this was working, I had almost all tests work. Except one weird one where the serialization was breaking. After spending some hours on this, I finally found the culprit: I had added my own defines for PRI?{8,16,32,64}, as I was initially using amiga-cross-toolchain, but switched to amiga-gcc while debugging the exception problem. amiga-cross-toolchain lacked those, but amiga-gcc actively undefined them, redefining them the wrong way, truncating the result to 32 bit. The solution here was to #define __have_longlong64. And after some more fixes, I then finally got this:

While this is already working, the porting effort to AmigaOS 3 is not done yet: I did not bother making sockets work yet and everything is still linked statically rather than having a .library. I will work on this in the coming days, but for working on it for only a day, I think this is enough progress :).

ObjFW 0.90.2 has been released

Created: 23.10.2017 21:40 UTC

I just released ObjFW 0.90.2.

As usual, you can get the tarballs and changelog here.

ObjFW, Frameworks, the App Store and Swift

Created: 20.10.2017 23:30 UTC

This week, I finally got scrypt-pwgen into the App Store (except France, because they have insane crypto regulations). This was actually quite a fun exercise, as this (to the best of my knowledge) is the first app to make it into the App Store that uses ObjFW. Initially, I was using ObjFW built as a .framework for this and it worked fine on my local device, but it confused the App Store a lot, and while the build would upload, it would then fail the processing on Apple's side. The immediate remedy was to just use ObjFW as a static library, which worked and pretty much let me get the app into the App Store immediately (except the first version being rejected, because it crashed as a category wasn't loaded due to the switch from a .framework to static linking). However, I really wanted this working with a .framework. Since copying the Xcode-built .frameworks over was annoying, I tried adding a subproject with ObjFW itself, but that was also annoying. I ended up adding support for building .frameworks to buildsys.mk and a script that builds a universal ObjFW.framework and ObjFW_Bridge.framework for all architectures + all simulator architectures, so that I can easily switch between device and simulator. This now works beautifully, and I can successfully upload it to the App Store, with just one caveat: Before uploading it to the App Store, I need to use lipo to strip the simulator architectures, as Apple does not like you uploading a .framework that contains support for unsupported architectures :).

All this looking into .frameworks gave me the idea to look into how well ObjFW.framework and ObjFW_Bridge.framework work with Swift. And after minor fixes, it worked exceptionally (pun intended!) well, except for one thing: Exceptions! But there was an easy solution, as Swift supports Blocks, and now there's a category on OFException in the bridge that allows you to do this:

import ObjFW

import ObjFW_Bridge

OFException.try({

OFOutOfMemoryException(requestedSize: 1234).throw()

}, catch: { (e: OFException) in

print("Caught \(e.class())")

}, finally: {

print("Finally")

})

So now it's even possible to use ObjC exceptions in Swift! Initially, I was converting OFExceptions into NSErrors, but while this is the most "native" mapping, it felt very ugly using it. The way it is now allows using it in a way that is almost the same as in ObjC.

ObjFW 0.90.1 has been released

Created: 20.08.2017 19:53 UTC

I just released ObjFW 0.90.1.

As usual, you can get the tarballs and change log here.

Interesting GCC optimization on SPARC64

Created: 19.08.2017 10:17 UTC

Today, I was looking into the following linker warning I got on OpenBSD/SPARC64:

/usr/bin/ld: warning: creating a DT_TEXTREL in a shared object.

This was in the runtime .so, so it was pretty obvious that this was coming from the hand-written lookup. readelf -r lookup-asm/lookup-asm.lib.o quickly revealed:

Relocation section '.rela.text' at offset 0x568 contains 6 entries:

Offset Info Type Sym. Value Sym. Name + Addend

00000000002c 000b00000029 R_SPARC_WDISP19 0000000000000000 objc_method_not_found + 0

000000000068 000c00000029 R_SPARC_WDISP19 0000000000000000 objc_method_not_found_ + 0

0000000000b4 000d00000011 R_SPARC_PC22 0000000000000000 _GLOBAL_OFFSET_TABLE_ + fffffffffffffffc

0000000000bc 000d00000010 R_SPARC_PC10 0000000000000000 _GLOBAL_OFFSET_TABLE_ + 4

0000000000c4 00060000000f R_SPARC_GOT22 00000000000000d4 nil_method + 0

0000000000c8 00060000000d R_SPARC_GOT10 00000000000000d4 nil_method + 0

Hm, yeah, that objc_method_not_found doesn't look right. Let's see what we have in the code (this is inside an assembler macro and \not_found is replaced with objc_method_not_found):

be,pn %xcc, \not_found

Ah, of course. While the linker handles a call fine in PIC mode, it apparently chokes on the branch if equal. Makes sense, considering the linker actually replaces the call with different instructions. And also explains why this warning did not appear on NetBSD/SPARC64: OpenBSD seems to have an older version of the linker due to avoiding GPL3 code.

Ok, so now we know what the solution is: Branch to a small stub instead that just does a call that then gets replaced by the linker. Let's see how GCC emits this if we want to have a tail call:

stub_func:

or %o7, %g0, %g1

call objc_not_found, 0

or %g1, %g0, %o7

This code confused me at first: Why is it setting %g1 to %o7? %g1 is volatile and the ABI doesn't specify anything about it at all. Also doesn't specify it in the PIC section. Why does it need to be set for the call? Is the ABI slightly different on OpenBSD? And why immediately set %o7 back to %g1? (Note: SPARC64 uses branch delay slots, so the instruction after the branch is executed before the branch is taken.)

This didn't seem to make any sense, until I found this in the ISA documentation:

The CALL instruction writes the contents of the PC, which points to the CALL instruction itself, into r[15] (out register 7) and then causes a delayed transfer of control to a PC-relative effective address. The value written into r[15] is visible to the instruction in the delay slot.

Aha! That's interesting. While it only says the value is visible in the branch delay slot, this also means that %o7 has already been set when we execute the branch delay slot. GCC exploits this in a nice way: It stores in %g1 the old value of %o7 and restores it during the call, meaning that the called function will get the same return address we had. This is why the volatile register %g1 can be used, as we don't even care about it anymore when the called function is executed, and why it sets it and immediately sets it back.

Anyway, since it just cost me 10 minutes to figure out why this code works and does what it should, I thought it might be worth blogging about this to save someone else those 10 minutes (as a quick search does not turn this up - hopefully it will now).

ObjFW 0.90 has been released

Created: 01.08.2017 14:34 UTC

I just released ObjFW 0.90. The big version jump is because the goal is to move towards a 1.0 release, as it is pretty stable now.

As usual, you can get the tarballs and change log here.

ObjFW on the Nintendo 3DS

Created: 20.03.2016 19:32 UTC

So, I bought a New Nintendo 3DS recently. Obviously, it did not take me long to port ObjFW to it. In fact, just a few days later, I had ObjFW working already, but there were still some minor issues. I fixed these minor issues now over the weekend and ObjFW is now fully supported on the Nintendo 3DS:

Sockets and threads are not supported yet, but I will add both very soon.

I did the initial development on 10.5.0-30E, but since then I downgraded my Nintendo 3DS to 9.2.0-20E so that I can always keep Homebrew, even if Nintendo releases an update that fixes the injection vectors. I start games in an emulated NAND which runs 10.7.0-32E now, which I start from my 9.2.0 using CakesFW, but run all Homebrew on the 9.2.0 (which allows kernel access). This way, I can use this device as a development device for Homebrew and to play all the recent games including online access.

New domain - new PGP key

Created: 28.12.2015 22:22 UTC

Since I have a new domain now (heap.zone) as the old one was not very international, I used that as an excuse to generate a new key with improved operational security. I will follow up with the details later, but the new key fingerprint is:

2438 8F8F 4A75 ECC4 FCBD E8C8 2DFF 526B B17F 76C6

The new key is signed by the old one, which is revoked now. The revocation also includes the fingerprint of the new key.

Objective-C 1 support dropped in ObjFW

Created: 29.11.2015 14:33 UTC

This weekend, I dropped support for Objective-C 1 in ObjFW and cleaned up the code a lot by making use of Objective-C 2 features. Objective-C 2 makes a lot of code much easier to read and the backwards compatibility to Objective-C 1 meant many features like properties, fast enumeration and optional protocols couldn't be fully used (they could be used by someone using ObjFW, but not in ObjFW itself).

The downside is that this increases the requirement from GCC ≥ 4.0 or Clang to GCC ≥ 4.6 or Clang. But since today even GCC 4.6 is quite old, there is no reason to still support even older versions, especially as this means making the code uglier, a lot even. A few platforms were dropped from GCC 4.6 that were still supported by GCC 4.0, but none of them are really interesting for ObjFW. The most interesting of these was BeOS, which can still be supported using a Haiku toolchain. The others were mostly old versions of OSes for which a new version exists that runs on the same hardware.

Apple GCC is unaffected by this: Apple's GCC supported Objective-C 2 since Mac OS X 10.5. This is noteworthy as this is the only compiler that works for OS X on PowerPC.

ObjFW 0.8.1 has been released

Created: 04.10.2015 12:35 UTC

I just released ObjFW 0.8.1.

As usual, you can get the tarballs and the change log here.

NetBSD on an x200

Created: 16.08.2015 08:14 UTC

I'm currently at the CCC Camp and bought myself a Lenovo x200 beforehand, as I didn't want to bring my MacBook Pro. Since I was in the mood for experimenting, I installed NetBSD on it, as it has been years since I last used NetBSD on a notebook (I'm using it on all my servers for more than a decade, though). To my surprise, everything worked out of the box and works perfectly. I didn't even have to hunt down a firmware for the WLAN chip, everything just worked. I even had hardware accelerated 3D support without any blobs, out of the box. The only thing I haven't gotten to work yet is standby. Well, technically, standby works - I just cannot get out of standby and have to power down the machine then.

I bought the x200 specifically because I wanted to flash CoreBoot on it, The x200 is pretty much the newest machine that works with CoreBoot without any blobs. I got some cables soldered on my SPI flash now and a connector soldered to the other end of the cables (thanks to zaolin!), but I haven't gotten to actually flashing it yet. It will be interesting to see how well the combination CoreBoot + NetBSD works, and if that maybe actually fixes my standby, as CoreBoot doesn't ignore the ACPI standard like Lenovo does. I'll definitely write another blog post once I got CoreBoot running.

ObjFW 0.8 has been released

Created: 14.08.2015 18:46 UTC

After way too long time (over 2 years since the last release!), I finally released ObjFW 0.8 just minutes ago. The differences to the previous release are bigger than ever and I recommend to read the changelog and strongly urge everyone to upgrade. As usual, download and changelog are here.

New PGP key - again, but this time on a Gnuk

Created: 13.02.2015 21:57 UTC

So, I changed my PGP key - again, I know. But there's a good reason for it: I now have my new key on a Gnuk. Well, to be more correct, on an FST-01 running Gnuk. The FST-01 is a small ARM board in the size of a USB stick that is based on an open hardware design. And Gnuk is a GPLv3 licensed implementation of the OpenPGP card specification for the FST-01.

After receiving my FST-01, I quickly realized how hard it is to actually generate a key in a secure environment from which I can then transfer it to the Gnuk. Since one of my requirements is to use Ed25519 for the signing key (as I want to sign all my Git commits and thus want small signatures), I had to update the FST-01 to Gnuk 1.1.4 first. And I had to update GnuPG to include a few fixes for GnuPG + Smartcards (while the Gnuk is not a smartcard, it behaves like one and speaks the OpenPGP card protocol). But how to do all that in a secure environment?

So I came up with a plan: I downloaded the latest ArchLinux install image, as it comes with at least GnuPG 2.1, which means I can at least generate an Ed25519 PGP key. I burned that on one machine, then verified the CD in another that was already running ArchLinux and thus had the ArchLinux key ring and then booted it on a third machine - just to make sure. It's important to note that I removed all hard drives and network connections from the machine I booted it on (and of course used one without (U)EFI or other things for sneaky backdoors - and just to be sure even disabled loading of the microcode updates in the boot loader).

Once I booted it, I generated a 4096 bit RSA certification key (the idea being that a.) everybody can at least import and sign my key and b.) every keyserver can handle it and thus can get the missing Ed25519 key on the next refresh as my key specifies a keyserver that can handle Ed25519), an Ed25519 subkey for signing, a 4096 bit RSA key for encryption (since Curve25519 support for encryption isn't there yet) and an Ed25519 key for authentication (useful for SSH!) and stored all keys on a USB thumb drive. After that, I removed the thumb drive and attached another thumb drive to which I only copied the public keys (so I can copy those to the machine with which I want to use the Gnuk). Then I shut down the machine and waited until enough time passed to make sure all contents of the RAM are gone.

Once enough time passed, I booted it again and this time gave internet connectivity to it. I then downloaded the necessary cross-compilers and Gnuk and applied some patches (and of course verified the hashes for all of them!). The ”applied some patches“ part is the result of several iterations of doing this, since I discovered 2 bugs which were quickly fixed. Once the firmware was built, I would flash it to the Gnuk, then plug in the Gnuk and set the signing and authentication key type to Ed25519.

Now I once again rebooted the machine with internet connectivity, downloaded the GnuPG sources, verified the tarball, applied the necessary patches (after verifying their hashes!) to it and rebuilt it. After that, I unplugged internet connectivity and plugged in the USB thumb drive with the private key and finally imported the signing key, encryption key and authentication key to the Gnuk with the patched GnuPG (note that the certification key is missing - this is because the OpenPGP card protocol has nothing for it and to further improve security as this is the only long-lived key; the subkeys can easily be replaced). Don't forget to change the Gnuk's PIN, though!

Since this is all quite a lot of manual work, especially as you need to mount tmpfs all over the place etc., I created scripts for the steps for which you need internet connectivity anyway: For building the Gnuk firmware and for building the patched GnuPG. These scripts will download everything that's required and verify all hashes, but obviously, you should check the scripts first and make sure the checksums in there are correct!

While the whole process right now feels like a lot of work, it really isn't that much work anymore with those two scripts. Things should only get better over time, as a new ArchLinux ISO will at some point contain a GnuPG with all the patches (GnuPG 2.1.2 has already been released and contains all the necessary patches) and the FST-01 will at some point most likely ship with a newer version of Gnuk.

In any case, when carefully doing everything in this order and exactly like written, there is no point where the private keys could leak into the internet (or some non-volatile storage other than the thumb drive holding the private key, because none is attached!).

Oh, and of course, here's my new fingerprint:

6CBB 47F8 A2BB F84D 9C54 1868 6795 57FE 2FF7 C07A

It will be used to sign all commits from now on.

By the way: The FST-01 can also be used as a true random number generator. The software for that is called NeuG.

Edit: I should note that you should not order the FST-01 with the shrink tube, as you cannot access the SWD port there! And I should also note that RSA 4096 takes 6 - 8 seconds on the FST-01. I consider this an advantage, though, as you then notice if something is signing / decrypting when it shouldn't, as the FST-01 has a blue LED that is lighting up when it signs / decrypts.

Edit 2: I noticed that basically all the entropy is coming from haveged on the ArchLinux install CD. I really don't trust haveged (a quick web search reveals a lot of reasons why you really shouldn't), so I decided to flash NeuG to my FST-01 and use that to add more entropy to the pool (after killing haveged and draining all the entropy it generated). Since rngd is not part of the install CD, this means I had to download it before I could generate the key. While this is a disadvantage security wise (because for that I was connected to the internet for a brief moment), I consider the risk low enough and the advantage of having a TRNG far outweights it.

In any case, the fingerprint of the new key generated with some randomness coming from NeuG is:

2D73 E456 EE94 12BC 9077 78DF 78D4 EEEF 482C B982

New GPG key

Created: 11.01.2015 00:47 UTC

I have a new GPG key now (signed by my old key). This key is a little bit special, though, as it requires at least GnuPG 2.1.

The reason for this is that it uses Ed25519 for the main key and RSA 4096 for the encryption key. Unfortunately, it's not possible yet to use Ed25519 for encryption, but this is expected to change soon with a new GnuPG point release. Another disadvantage is that most key servers are not able to handle such keys yet, but the software for the key servers already has support for Ed25519 keys commited, so all that's needed is that operators upgrade.

While this has a lot of disadvantages, I decided to give it a try anyway, as I think this is the right way to move forward. While ECC with the NIST curves has already been specified in an RFC, using Ed25519 so far has not. There is a draft from Werner Koch though and since GnuPG already implements it, I'm sure this is only a matter of time.

Another nice side effect of using Ed25519 is that signatures are much shorter, allowing me to sign every commit I do. I'm not sure yet whether I will sign ObjFW releases with the same key or with a new key signed by this key. Having a release signing key has the advantage that it's much harder to compromise that key, as it's only rarely used.

Edit: This seems to be a key server accepting Ed25519 keys.

Edit 2: I also have a 4096 bit RSA key now, in case you absolutely cannot upgrade to GnuPG 2.1 for whatever reasons (though you should, as even the old algorithms were hardened there). I will use both keys, but I will sign all my commits only with the Ed25519 key to keep the sizes of the repos reasonable, so if you want to verify those, you have no choice but to upgrade.

My Ed25519 and RSA key sign each other and their fingerprints are:

Ed25519: E8F4 B5D1 607C 6DDB A3C6 FA41 D8C2 8F99 13CE F75C

RSA4096: 2FA4 A252 B8DC C53A 1D34 E2E1 BD90 B760 3030 94D7

Keep in mind though that you should not completely trust the fingerprints you see here, as they are only as secure as TLS and the webserver are - and we all know TLS is not really secure.

Edit: The keys have been replaced.

ObjFW on bare metal ARM Cortex-M4

Created: 16.07.2014 14:55 UTC

Yesterday, I received a mail from Shotaro Uchida letting me know that he successfully ran ObjFW on a ARM Cortex-M4 board, namely the Silabs EFM32WG-DK3850. He even included a screenshot, but unfortunately it isn't that spectacular as there's not much indicating it's indeed running on an ARM Cortex-M4 board - maybe a more spectacular screenshot will follow, we'll see :).

Uchida even was so kind as to let me know what he changed. It turns out that most changes were just hacks to make his build environment behave and that ObjFW pretty much ran out of the box. We're currently working on getting it to work without any changes by fixing his build environment (it's currently a mix of GCC and Clang with Clang not properly integrated) and passing the right options to ./configure. His changes can be found here.

It's always great to see what others do with ObjFW and it fills me with joy to see people trying ObjFW on new platforms. Thanks a lot for sharing this, Uchida! I think this is a nice demonstration of how portable ObjFW really is. How many frameworks run almost out-of-the-box on bare metal? ;)

Edit: Shotaro sent me the specs for that Cortex-M4 and it's comparable to the Nintendo DS.

Edit 2: Shotaro has written a blog post about ObjFW on bare metal Cortex-M4.

ObjFW ported to Nintendo DS

Created: 27.04.2014 19:50 UTC

I just committed the initial port to the Nintendo DS. It's still lacking threads and sockets, but I plan to add those eventually. Also noteworthy is that you require an argv-compatible loader in order to use files. Unfortunately, there is nothing I can do about this, as this is a limitation of the SDK.

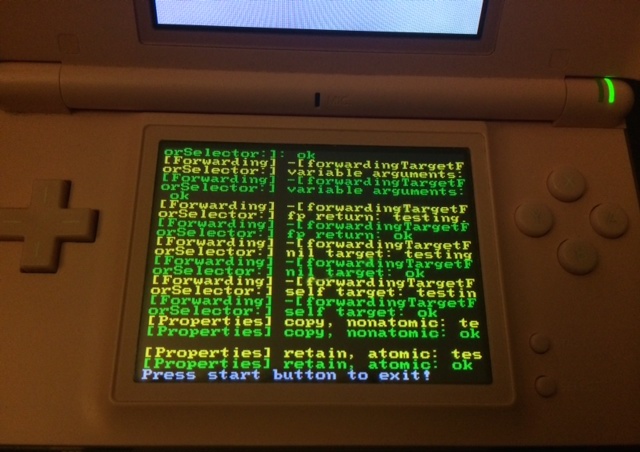

Anyway, a picture is worth more than words, so here's a picture of ObjFW's tests all running successfully on my girlfriend's sister's DS (I did most of the development using DeSmuME, since I own no hardware):

Oh, and this is most likely the device with the lowest hardware specs on which I ever tried ObjFW. Yet it's still quite fast! :)

Mobile optimization of the blog

Created: 29.09.2013 18:29 UTC

Today, I optimized the blog for mobile devices so that it is possible to read it without scrolling. This also introduces a nicer way to declare code blocks, so that those are still scrollable, but as a block that scrolls instead of the whole page. Previously, those were only <code> tags, but for scrolling, a <div> is needed.

So far, I only tested it with an iPhone 4, but it would be nice if others could test it with different devices and let me know their results.

As usual, the code has been already updated and can be found on the usual place.

Finding the origin of an unhandled exception

Created: 23.09.2013 10:09 UTC

As you might have read here before, ObjFW gained support to show backtraces on unhandled exceptions some time ago. This makes it easier to find where an exception was thrown first, as there are a lot of places where exceptions are caught, some cleanup done and then rethrown. Using just gdb, only the place of the last rethrow would be shown in the backtrace, but due to ObjFW generating a backtrace when the exception is created and storing it inside the exception object, it is possible to find out where the exception was created.

However, if you run the application in gdb now, you get ObjFW's nice output of the backtrace from when the exception was created, which contains the addresses and function names, but not the source lines. So this seems like a step forward (getting the place where the exception was created) followed by a step backward (no source line anymore) at first.

But this is not the case. When running an application inside gdb, you can still get the source line, even if the backtrace is outputted by ObjFW and not by gdb. The trick is to use ObjFW to output the backtrace and gdb to resolve an address to a source line. In order to view the source line in gdb, just use list *0xdeadbeef, where 0xdeadbeef is the address as outputted by ObjFW. Notice the * before the address, it is important and may not be omitted.

I hope this explains how you can use ObjFW's ability to output a backtrace in conjunction with gdb to easily find out the source code that created the exception.

How @""-literals work

Created: 02.08.2013 10:54 UTC

I was recently asked how the @""-literals work in the runtime and in ObjFW, which resulted in a lengthy explaination which I thought might be worth blogging.

Whenever the compiler finds a @""-literal like @"foo", the compiler first creates a struct for that string which looks like this:

static struct {

Class isa;

const char *string;

unsigned int length;

} constant_string_1 = { Nil, "foo", 3 };

This is basically an object which is not allocated on the heap, but resides in section .data and does not have its isa pointer set. As the isa pointer needs to be set correctly, some initialization is required by the runtime, for which the compiler creates another struct which looks like this:

static struct {

const char *class_name;

id instances[3];

} static_instances = {

"OFConstantString",

{

(id)&constant_string_1,

(id)&constant_string_2,

NULL

}

};

A pointer to static_instances is then stored in the symtab. The symtab contains pointers to all selectors used in the compilation unit, pointers to the structs for all classes implemented in the compilation unit, pointers to the structs for all categories implemented in the compilation unit and pointers to all static instances in the compilation unit, together with the number of classes and the number of categories. All pointers except the pointers to the selectors are stored in a single array. The first class is at index 0, the first category at index cls_def_cnt (the number of classes) and the first list of static instances at index cls_def_cnt + cat_def_cnt (the number of categories). Of course, there can be multiple lists of static instances, as not all static instances need to be of the same class, but in practice, they usually are. After the last list of static instances, the array is terminated with a NULL pointer.

This symtab is then pointed to by the module struct, which is a struct generated for every compilation unit that uses Objective-C. The module struct also contains the ABI version for the structs it references, the name of the compilation unit (this is usually unused) and its size.

Finally, the compiler emits a function that is declared with __attribute__((constructor)) which looks like this:

static void

init(void)

{

__objc_exec_class(&module);

}

__objc_exec_class is a function of the runtime that parses the module, the symtab, the classes etc. and of course also the static instances. It keeps a list of all static instances for which it could not resolve the class yet, as it is possible that a compilation unit containing static instances of class Foo is registered before the compilation unit containing class Foo is registered. Each time a new class is registered, the runtime checks that list to see if there are static instances whose class just became available and initializes them if that's the case. Eventually, all compilation units were registered and the runtime resolved all classes for the static instances, so that all static instances are valid objects.

While from the perspective of the runtime everything is done now, there is still some more to be done in ObjFW: As the object generated by the compiler and initialized by the runtime does not contain more than the C string and the length, it is necessary to calculate missing information like whether the string is a valid UTF-8 string, its unicode length, etc. In order to do this, instances of class OFConstantString call -[finishInitialization] on any message sent to it and then resend that same message to self. -[finishInitialization] calculates the missing information and class-swizzles the object to class OFString_const, so that the resending of the message in OFConstantString actually calls the correct code instead of doing the initialization again.

After all this, the @""-literal is finally fully initialized and behaves just like any other OFString

All structs used by the runtime can be found in src/runtime/runtime-private.h. The structs prefixed with objc_abi_ are the ones emitted by the compiler, while all that are only prefixed with objc_ are those used by the runtime. The structs generated by the compiler are actually not documented, and other runtimes don't use the strict separation between ABI structs and runtime structs: They only declare the runtime structs so that for example a class name string is stored in a Class variable and they just fix it in-place, while ObjFW's runtime uses two structs that point to the same data; the objc_abi_ structs are used before initialization and the objc_ structs after. This results in having structs that are exactly what the compiler emits and not adjusted to the runtime, so that runtime-private.h is actually what comes closest to a documentation of the ABI. (And yes, creating those struct declarations sometimes felt like reverse engineering something proprietary, as there was no documentation ;).)

PS: This is also the 100th blog post! :)

Sockets on the Wii

Created: 13.06.2013 01:46 UTC

I already committed initial support for sockets on the Wii yesterday, however, there were still a few bugs as mentioned in the commit.

In the commit message, I wrote that I was undecided whether I want to add workarounds in ObjFW or whether I want to fix the SDK. Today, I decided to do both and went ahead and implemented the workarounds in ObjFW while filing bugs for devkitPPC.

The first bug in the list was that binding to port 0 does not work on the Wii. I worked around this by having a variable start at 65532 which is decremented on each bind. This works as nothing else should be running on the Wii while executing homebrew code. However, it imposes a restriction to not manually bind to very high port numbers. The variable starts at 65532 as 65533 and 65534 are used by OFStreamObserver for the cancel socket and using the last port just didn't feel right.

The second bug was that gethostbyname() does not work for IPs. I looked around in the POSIX specification and found out that this behaviour is indeed not required by the standard, but it seems to be what everybody else does (at least I couldn't find any OS not accepting IPs for gethostbyname()). As this was not 100% standards compliant anyway, I decided to add some extra code that tries to parse the host string using inet_addr() first and only falls back to gethostbyname() if the former failed. If you are scared because you just read gethostbyname(): Yes, the SDK only provides that, even though the IOS seems to provide getaddrinfo(). And no, gethostbyname() is never used if getaddrinfo() is available ;).

For the two remaining bugs, the workarounds were quite simple:

gethostbyname() simply isn't needed anymore, as we don't bind to port 0 anymore on the Wii, but use our variable instead and thus don't need it anymore to find out to which port the socket was actually bound to. And the addition of the missing struct sockaddr_storage isn't even worth mentioning.

So, after these commits, sockets work with the vanilla devkitPPC SDK for the Wii.

_Unwind_Backtrace()

Created: 11.06.2013 23:05 UTC

As I already wrote in the edit of the previous blog entry, __builtin_return_address() will crash on many platforms under certain conditions. As a result, it was disabled on all architectures except PPC (this was the only one that seemed to work reliable with it) and backtrace() was used instead if available. However, backtrace() seems to be only available on systems with glibc and OS X.

Today, I stumbled upon _Unwind_Backtrace(), which is part of libgcc_eh. The disadvantage of this function is that it only works if unwind tables exist and has no fallback like backtrace() does. However, as ObjFW code always has unwind tables since it uses exceptions, this is no problem at all and the ideal solution: It is available on all systems that support ObjFW (because we already need the other _Unwind_* functions for exceptions, it does not work without libgcc_eh or an ABI-compatible replacement lib anyway).

I just implemented backtraces using _Unwind_Backtrace() in ObjFW and removed the code for __builtin_return_address() and backtrace(), as those have no advantage anymore. This means that backtraces are now available on all platforms supported by ObjFW and shown when an exception is not caught!

Backtraces for Exceptions

Created: 22.05.2013 21:42 UTC

I just implemented backtraces for exceptions. While at first, this does not seem to be worth the effort (especially if not using backtrace() from execinfo.h in order to be portable and not limited to platforms that aim to be compatible to glibc) as every debugger can do it, this has a huge advantage over using a debugger: It gets the location of where the exception was created rather than the location of where it was thrown!

But why does it make a difference if we get a backtrace when the exception is created or when it is thrown? Well, a common problem why many exceptions are hard to trace is that there is a lot of code that catches an exception, does some cleanup and then rethrows it. Using a debugger, you get the location of the last rethrow. But this is not where something actually went wrong! But if the backtrace is generated when the exception is created and then stored inside the exception, you can always get the backtrace of when the exception was created - which is what you're usually interested in.

And finally, to add even more convenience, the default handler for unhandled exceptions now also shows the backtrace from when the exception was created.

Edit: I had to partly revert it, as it turns out that __builtin_frame_address() just crashes on many platforms instead of returning NULL, like the documentation said. I should have expected this, considering that just crashing is what most of GCC's builtins do on many platforms… See here for details.

ObjFW on the Wii

Created: 27.04.2013 00:14 UTC

It's been quite a while since I last blogged something that's not a release announcement, so I decided that I'm going to use this blog in the future to give a report on the status of my projects. Today, I am going to show some progress I made on ObjFW in the past few days.

Recently, I got a Wii for 50€ from eBay. It was sold as being broken, though it

really wasn't (the DVD drive was said to not accept any discs, however, simply

using a small screw driver to push it in worked. After that, even ejecting it

and inserting a DVD the normal way worked). So it was only a matter of time

until I ported ObjFW to it. At first, I was stuck with weird crashes, which

turned out to be a typo in OFSystemInfo and resulted in it always

returning 0 as page size. Of course, in a lot of places, the page size is used

to allocate a buffer, and naturally, this would fail. But still, it was hard to

find out that this was causing the crashes, so it took me some time. After

that, the rest was easy. I added a lot of new checks to configure in order to

have it easier to port ObjFW in the future (there were a lot of places were it

was assumed that it's a POSIX system if it's not Win32

- this is no longer the case now) which are already in Git. I even have code

here that sets up a console and waits for some input after all tests have

been run (otherwise, it would return to the Homebrew Channel without having a

chance to read anyting) and it also pauses the output until a button is pressed

if a test failed, so that those aren't missed. However, this code is not in Git

yet, because I still need to implement file system access and tests requiring

files are just disabled for now. After that, I will commit it and implement

threads and sockets (so for now, --disable-threads and

--disable-sockets are required).

Anyway, a picture is worth a thousand words, so here's one of my Wii having

successfully ran all ObjFW tests (except files, sockets and threads, of course

- but I'm confident those will follow in the next few days):

Edit: The Wii port is now committed. However, threads and sockets are not implemented yet, but files are.

Clang 3.2 has been released!

Created: 21.12.2012 16:54 UTC

Yesterday, Clang 3.2 has been released, which incorporates all of my patches for Clang. This is great news for ObjFW, as this means Clang 3.2 is the first release with the -fobjc-runtime=objfw option, which makes it possible to support all features and optimizations of the ObjFW runtime (for example ARC, the new ObjC literals, direct class references, etc.).

Before the Clang 3.2 release, it was necessary to get Clang from trunk and manually compile it in order to be able to use all of ObjFW's features. As distributions will start to integrate Clang 3.2 soon, this means you can soon install Clang from your distribution and use all ObjFW features without having to worry about compiling Clang yourself. This should greatly simply setting up ObjFW with all features.

Special thanks go to John McCall from Apple here, who made the architectural changes to Clang to have an -fobjc-runtime= switch, which made it possible for me to implement -fobjc-runtime=objfw and add a new class for targetting the ObjFW runtime to Clang. He also was the one who reviewed and committed most of my patches.

ObjFW 0.7.1 has been released

Created: 12.11.2012 11:26 UTC

I just released ObjFW 0.7.1.

As usual, you can get the tarballs and the change log here.

ObjFW 0.7 has been released

Created: 27.10.2012 16:35 UTC

I just released ObjFW 0.7.

As usual, you can get the tarballs and the change log here.

Secure anonymous Git access

Created: 03.10.2012 11:25 UTC

Today, I setup the smart HTTPS protocol for Git in order to allow secure anonymous access to the repositories hosted at webkeks.org. They can be reached under the URL

https://webkeks.org/git/$repo.git

now.

As the git daemon for the unencrypted Git protocol was always a pain, I disabled it now that there is an alternative, so please update your local checkouts the the new URL.

Those who had trouble with a corporate firewall blocking the Git protocol should be able to clone the repositories now, so that's another advantage.

Why I changed to Git after hating it

Created: 19.03.2012 20:08 UTC

Many might remember all the rants about Git from me, so for them, this might come as a surprise, but: Today, I switched a few of my repositories to Git, including ObjFW.

The rationale behind this is that most people know Git these days and DVCS equals Git for them, which means people are more likely to contribute if a repository is a Git repository, but also leads to software only supporting Git and not Mercurial. This also means the manpower behind Git has grown a lot, in fact, it has grown so much that Mercurial has trouble catching up with Git. This means Git offers a lot of nice features which Mercurial is missing unfortunately.

So, I played with Git a few days and found out that after getting used to it and creating a few aliases, it's actually usable. The trouble of learning how things are done differently in Git (mostly worse) pays off due to the features Git offers over Mercurial.

With the switch to Git, there also comes a new web interface here at WebKeks.org, which looks much nicer (see here) and which supports syntax highlighting - even for Objective-C.

Blog software updated

Created: 01.03.2012 16:46 UTC

I just updated the blog software and cleaned up the code a little.

While the code cleanup isn't that interesting, I noticed an interesting fact with blog aggregators that are often called "planet":

I noticed that some of them (namely Planet Symlink) are not able to differentiate between the <updated> and the <published> tag, which resulted in Planet Symlink showing old entries at the top again, just because the <updated> tag was changed. You can currently see all of my past blog posts there, again.

It even got worse: One might accept the fact that it orders by the <updated> tag, and some might even consider that a feature (IMHO, it's not a feature, as it just kills the timeline…), but it actually said on the website that the blog post was created at the date specified in the <updated> tag. Did they never read the ATOM spec to see the difference between <updated> and <published>?

Anyway, the blog update is done. The code I published has already been updated. If you happen to use it and want to use the updated code, keep in mind the date format changed to a more sane one (in the past, it was just copied from the data file, never parsed - it's parsed now. And be sure to have a 1 second delay between updating them, so weird newsreaders don't get confused by two entries having the same <updated> tag). This is also the reason why the <updated> tag changed for all blog posts, as I had to adjust them all.

ObjFW 0.6 has been released

Created: 27.02.2012 14:05 UTC

I just released ObjFW 0.6. This time, the differences are really huge and I highly recommend reading the changelog. As usual, download and changelog are here.

ObjFW 0.5.4 has been released

Created: 30.08.2011 16:45 UTC

I just released ObjFW 0.5.4. As usual, download and changelog are here.

ObjFW 0.5.3 has been released

Created: 30.06.2011 23:53 UTC

I just released ObjFW 0.5.3. As usual, download and changelog are here.

Git? Igitt!

Created: 26.04.2011 12:10 UTC

Today, I gave Git another try since we are using it at university and I'm currently looking into Mac Homebrew (MacPorts is starting to get reeeeally annoying), which is also using Git for everything. But after only 5 minutes, I noticed again how unbearable it is and how much pain even simple stuff is with it.

Since I'm a Mercurial fanboy, I of course know about hg-git. I already used it for simple stuff and it worked great. But I never had to push to a Git repository with branches so far, so I was amazed today about how well it works. Git branches are translated to Mercurial bookmarks and if you just hg up to the bookmark and do a commit + push, it actually goes to the right branch in Git.

So, if you too think that Git is a huge PITA and prefer Mercurial, give hg-git a try and don't bother with Git anymore.

PS: If you are wondering about the subject of this blog entry: “Igitt” is German and means “Yuck!”.

ObjFW 0.5.2

Created: 25.04.2011 18:50 UTC

ObjFW 0.5.2 has just been released. As usual, the download is here and the change log here.

ObjFW 0.5.1

Created: 21.04.2011 11:29 UTC

ObjFW 0.5.1 has just been released. As usual, the download is here and the change log here.

ObjFW 0.5

Created: 09.04.2011 20:41 UTC

ObjFW 0.5 has just been released. As usual, the download is here and the change log here.

ObjFW on the PSP

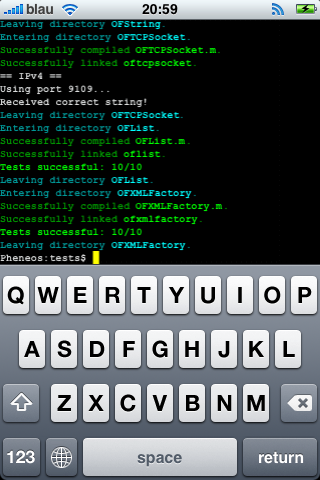

Created: 10.02.2011 21:13 UTC

I just ported ObjFW to the PSP. There were quite a few oddities and bugs on the PSP I had to fix or work around (like fix a broken libobjc, work around a broken asprintf, etc.), but it finally works.

Of course, I had to post a "screenshot":

Don't be confused about the OFXMLElementBuilder test being between those OFXMLParser tests: The reason is that the PSP wraps from the last line to the first and does not scroll, so everything is as it is supposed to be.

Change of language

Created: 07.02.2011 22:41 UTC

Seeing how little I posted lately and considering that some of the stuff I have been working on recently might be interesting for a broader international audience, I decided to change the language of my blog to English.

I'm going to mostly talk about ObjFW, Objective-C and XMPP here. Attending FOSDEM this year has shown me that there's clearly interest in these topics, so this is what I'm going for.